L’IA révolutionne la recherche d’informations… mais à quel prix ?

Les moteurs de recherche à intelligence artificielle (IA) promettent un accès rapide et synthétique à l’information. Gemini, Perplexity, ChatGPT et d’autres outils de recherche générative se positionnent comme des alternatives aux moteurs traditionnels. Pourtant, une étude du Columbia Journalism Review (CJR) révèle une faille majeure : ces outils peinent à citer correctement leurs sources. En analysant huit moteurs IA, les chercheurs ont constaté qu’ils attribuent souvent mal les contenus d’actualité, fabriquent parfois des liens inexistants et s’appuient sur des versions syndiquées d’articles, rendant la vérification difficile. Cette étude pose une question cruciale : comment intégrer ces outils dans une stratégie de contenu sans sacrifier la rigueur et la transparence de l’information ?

Une étude sur la fiabilité des citations des moteurs IA

Le Tow Center for Digital Journalism du CJR a évalué huit moteurs de recherche à IA afin d’examiner leur capacité à citer correctement les sources d’actualités.

Méthodologie

- 1 600 requêtes soumises à ces outils

- Analyse de 10 articles issus de 20 éditeurs différents

- Vérification de la précision des citations (nom de l’article, éditeur et URL correcte)

Les résultats sont préoccupants et mettent en évidence d’importantes lacunes en matière de sourcing.

Des erreurs massives et des sources floues

Une précision très variable

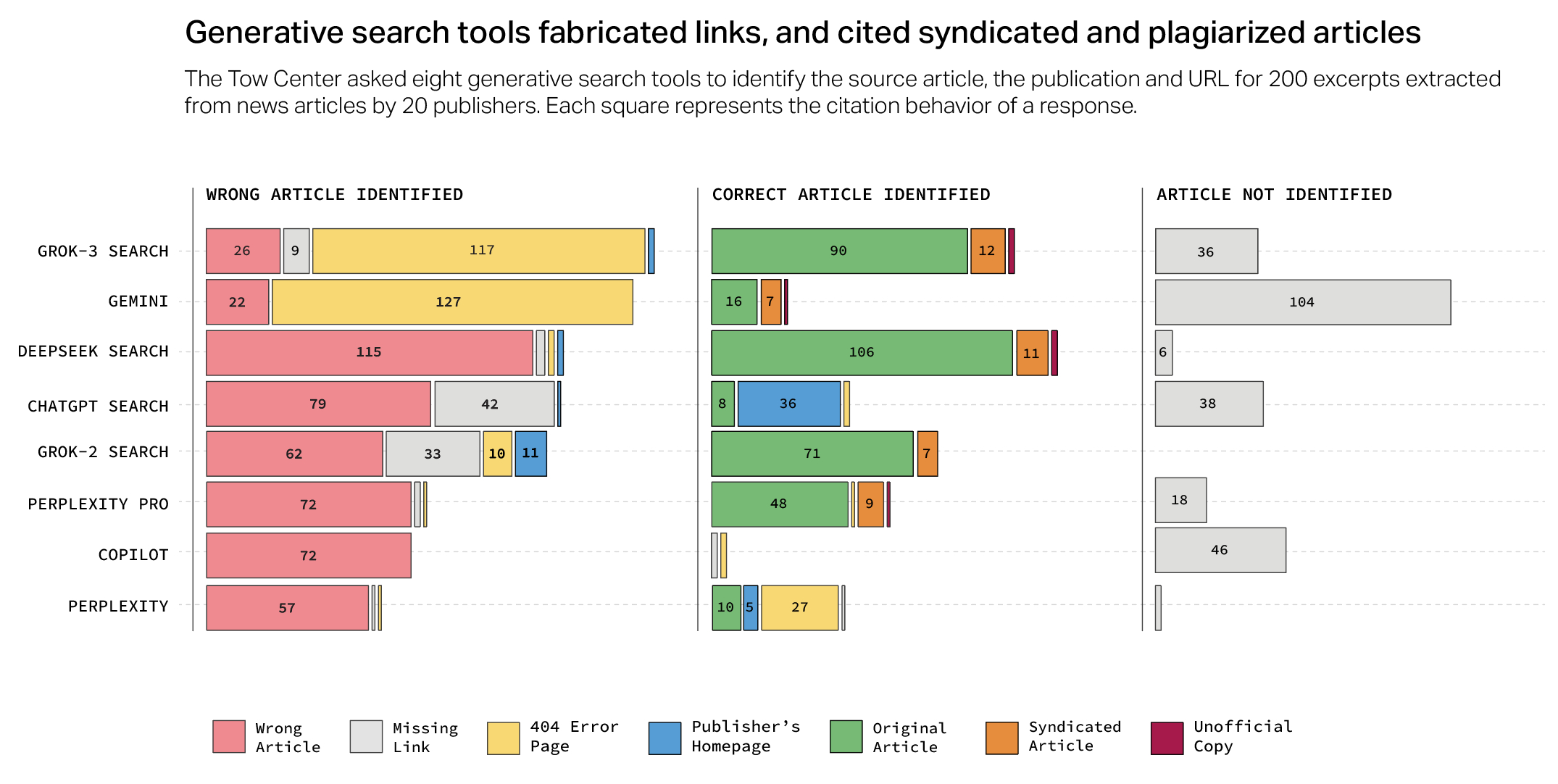

L’étude révèle que la majorité des moteurs IA testés produisent des réponses erronées dans plus de 60 % des cas. Certains outils se distinguent par leur manque flagrant de fiabilité :

- Perplexity : 37 % d’erreurs

- Google Gemini : 54 % d’erreurs

- Grok 3 : 94 % d’erreurs

Des citations approximatives et parfois inventées

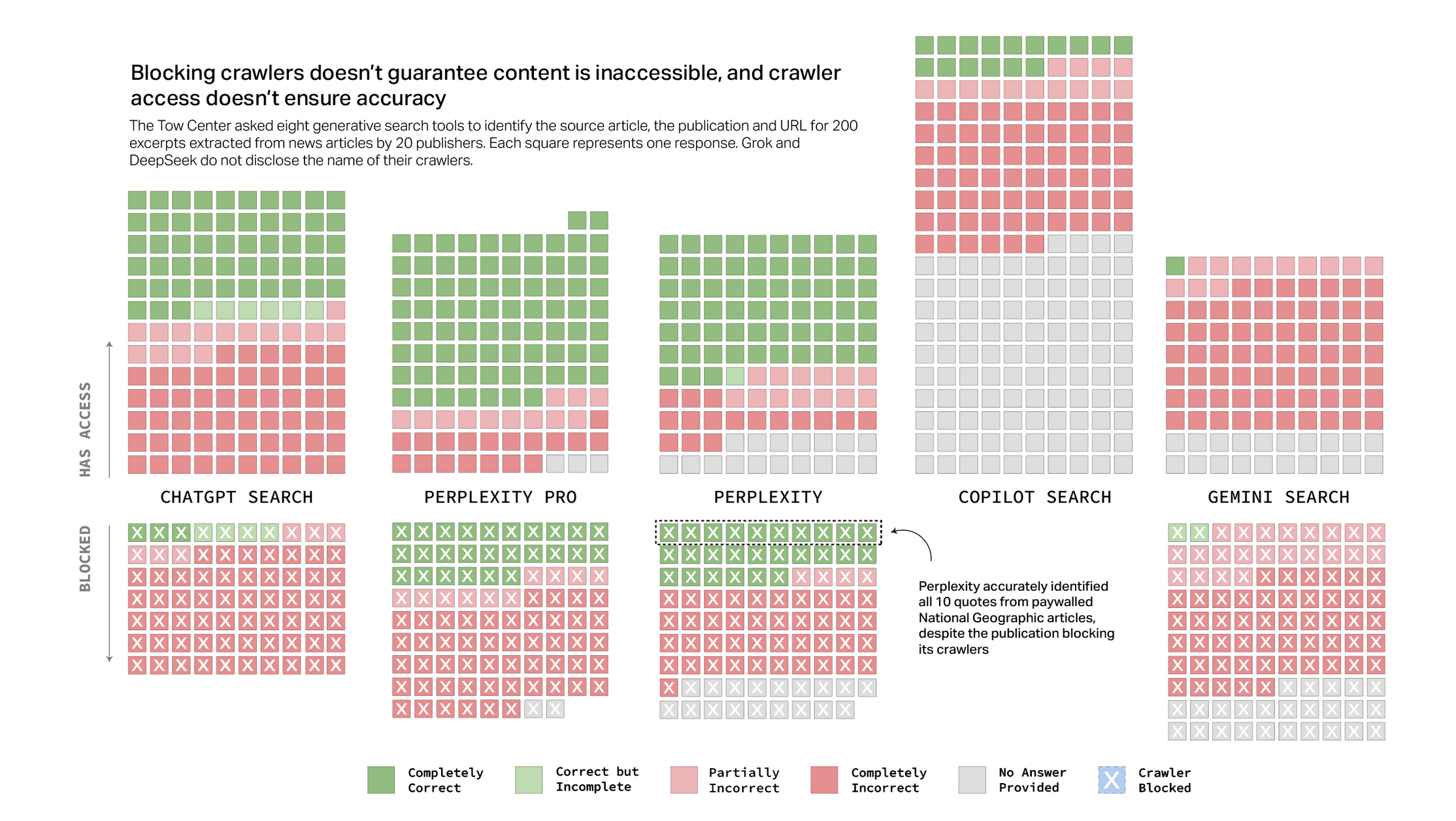

- Les moteurs testés ont généré des citations incorrectes et des liens inexistants.

- Certains ont renvoyé vers des versions syndiquées d’articles, compliquant l’identification des sources originales.

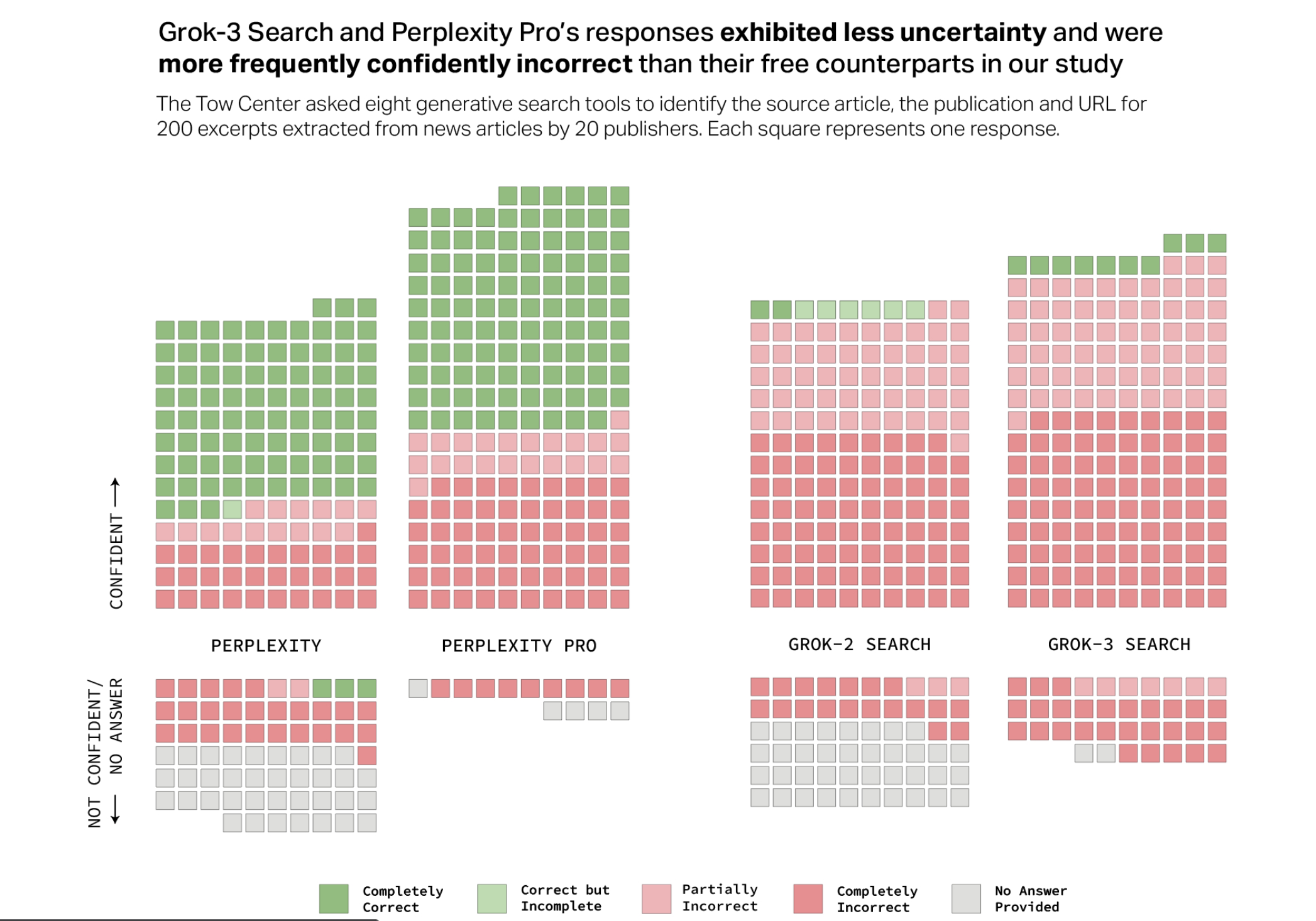

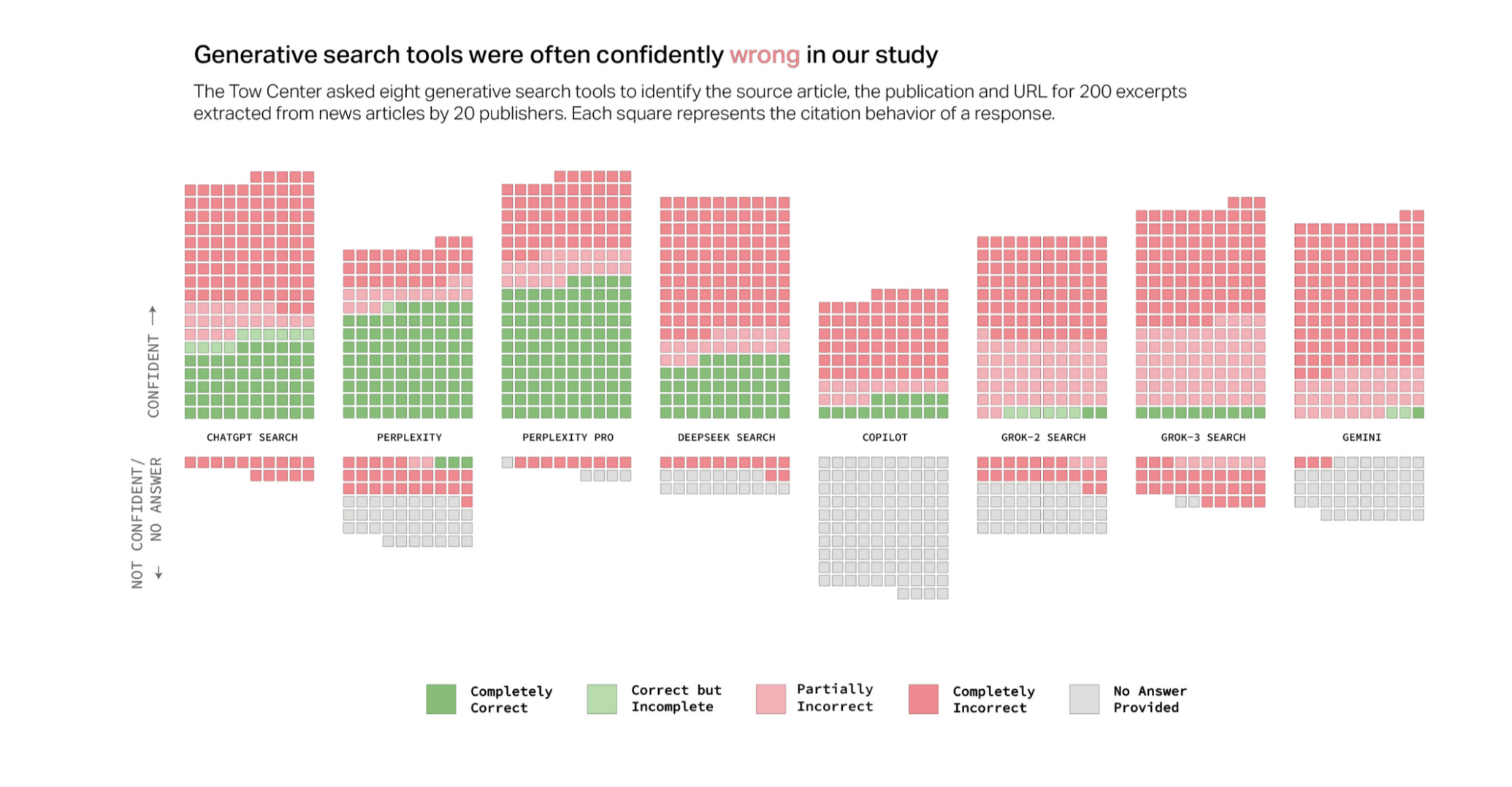

Une confiance excessive dans les réponses

- ChatGPT a fourni 134 réponses incorrectes sur 200, mais n’a exprimé un doute que dans 15 cas.

- Aucun des chatbots testés n’a refusé de répondre, même lorsque les informations étaient manifestement erronées ou impossibles à vérifier.

Pourquoi ces lacunes posent-elles problème ?

Un impact direct sur la crédibilité de l’information

Si les moteurs IA ne peuvent garantir une citation correcte des sources, leur fiabilité en tant qu’outil de recherche est remise en question. L’utilisateur moyen, peu enclin à vérifier chaque référence, risque d’absorber des informations mal attribuées ou tronquées.

Un manque de reconnaissance pour les éditeurs de contenus

Les médias et éditeurs d’actualités investissent du temps et des ressources dans la production d’informations fiables. Si les moteurs IA exploitent ces contenus sans les créditer correctement, ils privent ces acteurs d’un trafic légitime et affaiblissent l’écosystème de l’information.

Un risque accru de désinformation

Lorsque les sources sont mal attribuées ou que des citations sont inventées, le risque de diffusion de fausses informations augmente. Ces erreurs, amplifiées par l’IA, peuvent nuire à la compréhension des sujets d’actualité et alimenter la défiance envers les médias.

L’IA : un outil puissant mais imparfait

Cette étude rappelle un principe fondamental : l’IA, aussi performante soit-elle, ne peut se substituer à l’interprétation humaine et à une stratégie de contenu bien pensée, en marketing par exemple. Il faut donc séparer le bon grain de l’ivraie.

Ce que l’IA peut apporter

- Une analyse rapide et une synthèse efficace des informations

- Une capacité à traiter un grand volume de données en peu de temps

- Un outil d’aide à la recherche et à la structuration de contenus

Ce que l’IA ne remplace pas

- L’expertise humaine dans l’évaluation et la hiérarchisation des sources

- La capacité à contextualiser et à vérifier l’information

- Une stratégie éditoriale réfléchie, reposant sur une structure solide et une co-création avec des experts, internes ou externes à l’entreprise.

Conclusion : l’IA, un levier à utiliser avec discernement

Les moteurs de recherche IA offrent des perspectives intéressantes pour l’accès à l’information, mais leur incapacité à citer correctement les sources constitue une limite majeure. Une utilisation aveugle de ces outils peut fragiliser la crédibilité des contenus et nourrir la désinformation.

L’IA doit être considérée comme un assistant, et non comme une source fiable en soi. Une supervision humaine rigoureuse reste indispensable pour garantir la qualité et la véracité des contenus. Chez Nutrimedia, nous sommes convaincus que toute stratégie de contenu doit être structurée, sourcée et validée par des experts.

Et vous, avez-vous déjà remarqué des erreurs de citation dans les réponses fournies par les moteurs IA ? Partagez votre expérience en commentaires.